从英伟达推出离线聊天机器人看2024年三个落地场景

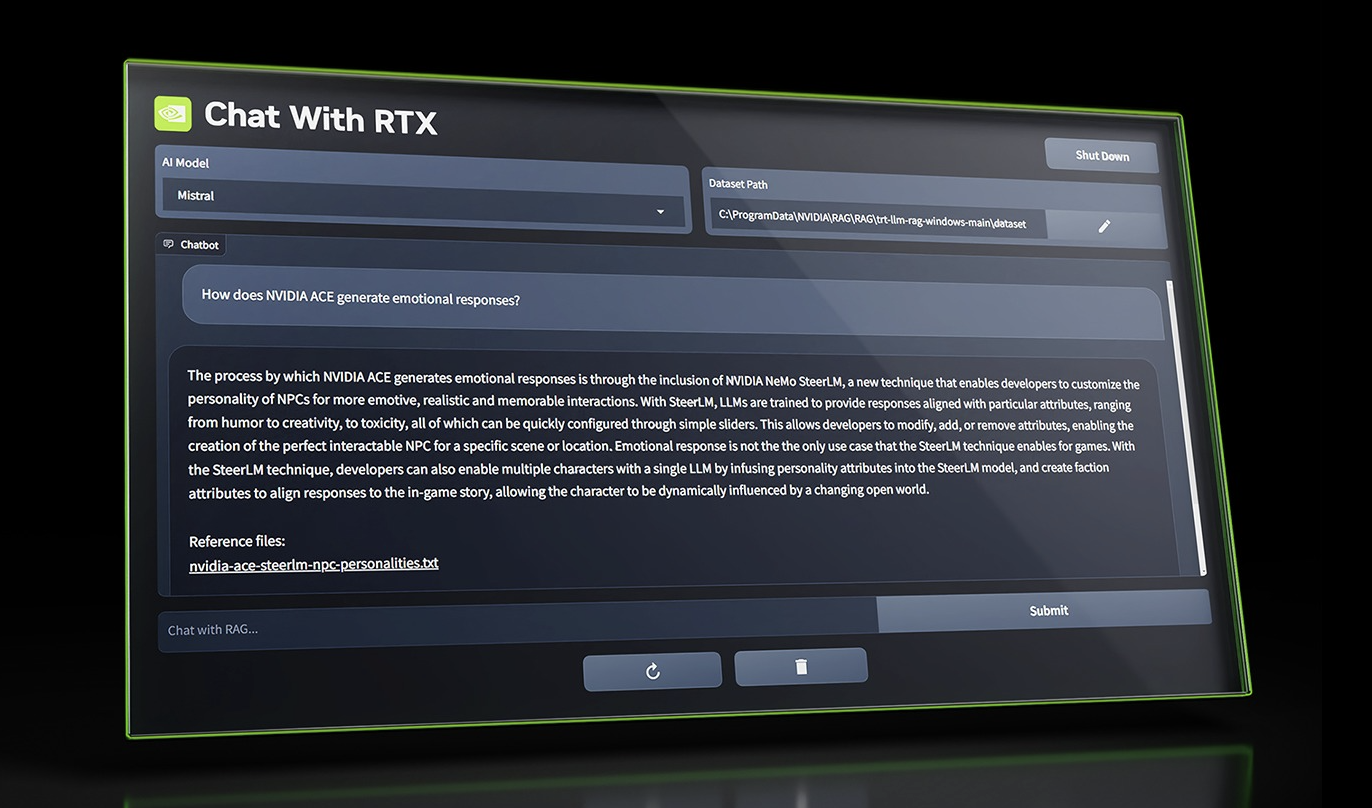

英伟达Nvidia近期发布了一款名为“Chat with RTX”的工具,该工具专为GeForce RTX 30系列和40系列显卡的所有者设计,让他们能够在Windows PC上脱机运行AI聊天机器人,类似离线版ChatGPT。

这款Chat with RTX工具允许用户根据个人需求定制GenAI模型,其功能类似于OpenAI的ChatGPT。用户可以将该工具与文档、文件和笔记相连接,进而进行查询。Nvidia在Demo中提到:“用户无需再费心搜索笔记或保存的内容,只需简单输入查询即可。例如,输入‘我伴侣在拉斯维加斯推荐的餐厅是哪家?’,Chat with RTX便会扫描用户指定的本地文件,并给出带有上下文的答案。”

Chat with RTX默认采用的是AI初创公司Mistral的开源模型,但也兼容其他基于文本的模型,包括Meta的Llama 2。不过,Nvidia也提醒用户,下载所有必要的文件将占用相当大的存储空间,具体大小取决于所选模型,范围在50GB至100GB之间。

目前,Chat with RTX支持文本、PDF、.doc、.docx和.xml等多种格式。用户只需将应用程序指向包含这些受支持文件的文件夹,这些文件就会被加载到模型的微调数据集中。此外,Chat with RTX还能接收YouTube播放列表的URL,加载播放列表中视频的转录内容,使所选模型能够查询这些视频内容。

但当前Chat with RTX这款工具仍有一些限制,比如该工具无法记住上下文,这意味着在回答后续问题时,它不会考虑任何先前的问题。例如,如果用户先问“北美普通鸟类是什么?”,然后接着问“它的颜色是什么?”,Chat with RTX将不会理解“它”指的是鸟类。

从趋势上来看Chat with RTX为用户在本地运行AI模型提供了一种更便捷的方式。模型离线化这一趋势正在逐渐增长。能够离线运行GenAI模型的设备,包括PC、智能手机、物联网设备和网络设备正在增长,离线模型不仅更加私密,因为它们处理的数据永远不会离开运行设备,而且比云托管模型具有更低的延迟和更具成本效益:

一、离线语音模型

离线AI模型广泛应用于智能设备,如机器人、汽车、音箱等,提供即插即用、稳定且私密的语音识别服务。相较于云端模型,离线AI解决了配网、网络稳定性及隐私泄露等问题。实现离线NLP需整合芯片、算法、软件及语音处理技术,以提升用户体验,为未来智能设备标配功能奠定基础。市场上虽有挑战,但离线AI前景广阔,值得期待。

二、离线图片模型

离线图片生成大模型在多个领域有着广泛应用。在创作和艺术领域,设计师和创作者可以利用其进行图像生成和风格迁移。在内容创作和广告设计方面,它能生成高质量视觉内容。此外,医学、地球观测和图像处理领域也能受益。在CES2024上,联想展示了新款Windows 11 Yoga笔记本电脑,配备联想Yoga Creator Zone软件,用户可轻松将文本描述或草图转为图像,无需复杂设置。这展现了离线模型在实际应用中的潜力和价值,为创作者提供简单、私密的创作体验。

三、私有云的离线防泄漏解决方案

VMware总部位于美国加州帕洛阿尔托(Palo Alto),是全球云基础架构和移动商务解决方案厂商。在今年的VMware Explore大会上,VMware积极进军生成式AI新领域,推出了多项创新服务。其中包括Private AI,这是一项跨云新服务,支持多云环境下的企业生成式AI模型的训练、测试和部署。此外,VMware还与Nvidia合作,共同推出适用于离线环境的方案,帮助企业更容易开发和定制自己的LLM模型,从而降低内部数据泄露的风险。

版权声明

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处。如若内容有涉嫌抄袭侵权/违法违规/事实不符,请点击 举报 进行投诉反馈!