开年1.8亿骗局!AI改变犯罪手段,Sora可能沦为诈骗工具?

不久前,香港警方透露了一场涉及深度AI造假技术的复杂骗局,一家跨国公司的香港办事处遭受了高达1.8亿元的重大财务损失。这已经不是第一起有关AI的诈骗了,此前就曾有骗子利用AI换脸和模仿声音的技术进行过多起诈骗。

近期OpenAI Sora的横空出世再次令我们震惊AI技术发展的迅速与强大,在震撼其能力强大之余也不免让我们担心这些前沿技术被诈骗份子利用又将如何应对。

一、AI换脸CFO诈骗1.8亿

据香港警方透露,这场高达1.8亿元的骗局以该公司首席财务官和其他员工的数字重建版本为特色,他们出现在视频电话会议中,指示员工转移资金。这家跨国公司的财务人员被冒充该公司驻英国首席财务官的人要求进行所谓的秘密交易,而最初的怀疑被深度伪造技术所打消。

这名员工在收到一条据称来自该公司驻英国首席财务官的消息后开始产生怀疑。最初,该工作人员怀疑这是一封网络钓鱼电子邮件,因为它谈到需要进行秘密交易。然而,在视频通话后,这名员工放下了最初的疑虑,因为其他出席的人看起来和听起来都像他认识的同事。最终这名员工相信电话中的其他人都是真实的,因此同意汇出总计 2 亿港元(约合 2560 万美元),当这名员工后来向公司总部核实时,才发现涉及假首席财务官的骗局。

香港警方表示,这已经不是第一起严重使用该技术的案件了,骗子利用AI换脸与声音模仿技术修改公开视频和其他镜头,以骗取人们的钱财。此前的多起案例已有六人被捕,但目前还没有迹象表明最近这起诈骗案的幕后黑手已被逮捕。

同时,香港警方称去年7月至9月期间,有八张被盗的香港身份证(均已被失主报失)被用来提出90份贷款申请和54个银行账户注册。AI换脸技术至少有20次被用来模仿身份证上的人企图欺骗面部识别程序。仅仅只是简单的AI换脸和模仿技术就已经让诈骗份子如此猖獗,如果是更加强大的AI视频技术呢?

二、功能强大的Sora也可能沦为诈骗工具?

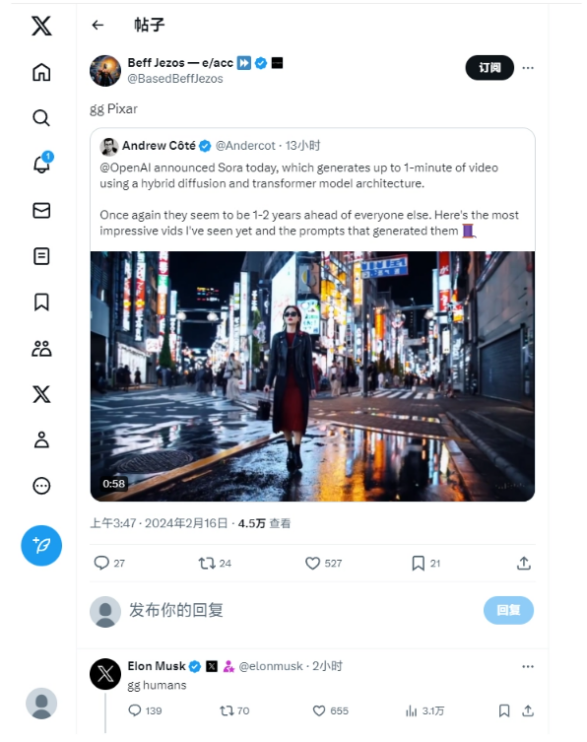

这两天最令人津津乐道的就是OpenAI推出的全新AIGC模型Sora了,其功能让无数人感到震惊。据介绍,Sora可以直接输出长达60秒的视频,并且包含高度细致的背景、复杂的多角度镜头,以及富有情感的多个角色。

目前官网上已经更新了48个视频demo,在这些demo中,Sora不仅能准确呈现细节,还能理解物体在物理世界中的存在,并生成具有丰富情感的角色。该模型还可以根据提示、静止图像甚至填补现有视频中的缺失帧来生成视频。

不少科技圈名人都发出了惊叹,马斯克直接在社交平台上发布短评“GG humans”(GG是电子竞技中常用的术语,意为“Good Games”,通常用来表示对对手的认可和自己认输的态度。)。马斯克的这一评价,似乎是在暗示人类在视频生成领域已经被Sora所超越。

360公司董事长周鸿祎则直接在朋友圈发文称,一旦AI能够接上摄像头,观看并理解世界上所有的电影,它对世界的理解能力将远远超过仅仅通过文字学习所能达到的水平。

Sora除了可以将文本转化为视频,还能接受其他类型的输入提示,如已经存在的图像或视频,也就是说Sora具备很强的视频拓展功能。看到这里,相信大家已经对Sora的强大有了一定的认知,那么现在试想一下,如果诈骗份子利用这个工具再精心策划一个骗局,将造成多么难以想象的结果。

举个简单的例子,骗子利用Sora生成一个你的熟人出现“意外事故”的视频和正在医院被推入抢救室的视频,同时再利用特殊方式恶意造成当事人电话占线,社交账号被盗,这时在打电话索要“手术费”。或许这一系列操作下来,被诈骗的人可能很容易就上当受骗。

2023年4月20日发生在内蒙古包头市的一起金额高达430万元的诈骗案件,就是利用AI换脸技术得手的。当天,郭先生接到来自好友的求助电话,对方称自己在外地竞标,需要430万元保证金。巨大的金额也让郭先生产生了怀疑,于是拨打视频通话确认对方身份,近乎一模一样的面容与声音让郭先生消除了疑虑。短短十分钟,430万元便已被转入骗子账户。好在事后经再次打电话确认,郭先生识破骗局及时报警,300多万元受骗金额被冻结。

当然,要做到这一切并不容易。首先Sora本身还并不完善,无法将现实世界中的所有信息都精确掌握,在展示视频中也经常出现违背物理规则的内容,例如玻璃碎裂的因果过程、四条腿的蚂蚁等等。

Sora这“人工智障”的表现,也让大家着实松了一口气。虽说确实生成一些足够惊艳的视频,但Sora离「扔进一部小说,生成一部电影」,应该还差得远呢。科技并没有在普通大众不知道的情况下飞跃太多,面对由此产生的诈骗手段也不会过于担忧。

其次是OpenAI自身有着严格的规则限制用户用以“不合法”的使用,同时随着AI技术的进步,相关法律法规也正逐步完善;最重要的是,我们个人随着接触事物的丰富而逐渐增长知识,或许对于一些粗劣的诈骗手段早已了然于胸,但科技迅速发展的当下各式新鲜诈骗手段频出,我们需要保持着较高的警惕性。

三、AI 诈骗并不新,但跟不上时代就要小心了

刚刚过去的2023 年被称为生成式 AI 的元年,不仅有大量文生图的工具还有Pika、Sora这种视频模型。在各种新鲜技术层出不穷的当下,在普通人还认为“好玩”的时候,或许一些老年人已经处于被骗的风险中了。

技术是把双刃剑的道理人人明白,Elevenlabs 可以让有语言障碍的人发声,HeyGen 让霉霉对口型说出不带翻译腔的中文,妙鸭相机让人足不出户收获精修证件照,技术的光明面和阴暗面并无长短,只是客观存在罢了。

一月底,人工智能生成的美国流行歌星泰勒·斯威夫特的色情图像在社交媒体上传播,凸显了人工智能技术带来的潜在破坏性。这些照片展示了这位歌手的性暗示和露骨姿势,在从社交平台上删除之前,这些照片已被观看了数千万次。

即便身为名人,对此也毫无办法,更何况是一些逐渐与时代脱节的老年人呢?对于很多中老年来说,智能手机和互联网本来就玩不明白,现在 AI 又来捣乱了。AI 时代,文字、声音、图片和视频都有可能是假的,甚至以组合形式上场,骗子伪造的身份更加具体,诈骗也更加对症下药和真情实感,让中老年受骗的概率更高。

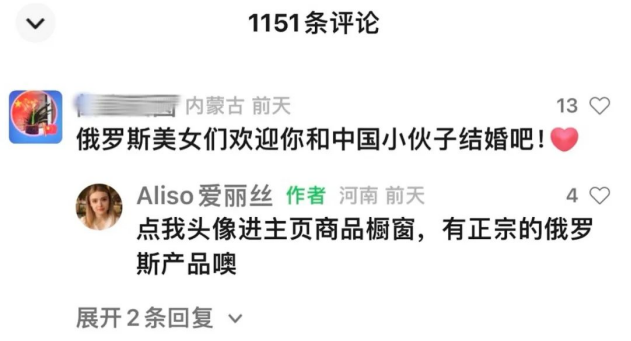

例如最近视频号冒出了不少「俄罗斯美女」。她们个个肤白貌美,普通话流畅但断句和咬字奇怪,声调和前后鼻音读不准,乍一看上去就是非常符合大众认知的外国人。她们热情,也热爱中国文化,为视频打上「俄罗斯女孩在中国」「中俄友谊」之类的标签,为观众朋友带来「家乡特产」的牛筋肠、大列巴、羊奶粉、酸黄瓜、巧克力、手工皂。

但实际上这些俄罗斯美女都是 AI,平台贴心地标注了。通过她们虚化夸张的模糊背景、没抠好的头发丝、循环的几套表情和动作、过于接地气的台词,我们也能分辨一二。

不过评论区的一些中老年并不能分辨出来,真心希望她们留下来,「俄罗斯美女」们回复时也只挂念着自己的任务,完成了一场不动声色的软性诈骗。如果真的出于相信的理由而购买到了不符合标准的商品,到时候又找不到人申诉,可就真是“有苦难言”了。

四、写在最后

不管技术如何发展,很多诈骗的套路万变不离其宗:窃取隐私,利用恐惧、贪欲、情绪价值编故事,冒充熟人或包装自己获取信任,图穷匕见以钱为最终目的。

像Sora这样功能强大的AI工具目前并不少见,随着科技的飞速发展还会愈发多样且完美,而在这个过程中相关法律法规也将会逐步健全。我们不必对技术的发展感到担忧,技术是服务于每一个人的,只要我们与时俱进保持警惕心,就能共同走向一个技术不被恐惧而是被合理使用的未来。

作者:孙浩南

来源公众号:元宇宙新声

版权声明

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处。如若内容有涉嫌抄袭侵权/违法违规/事实不符,请点击 举报 进行投诉反馈!