大模型价格,真正“捅穿地心”

太狠了!

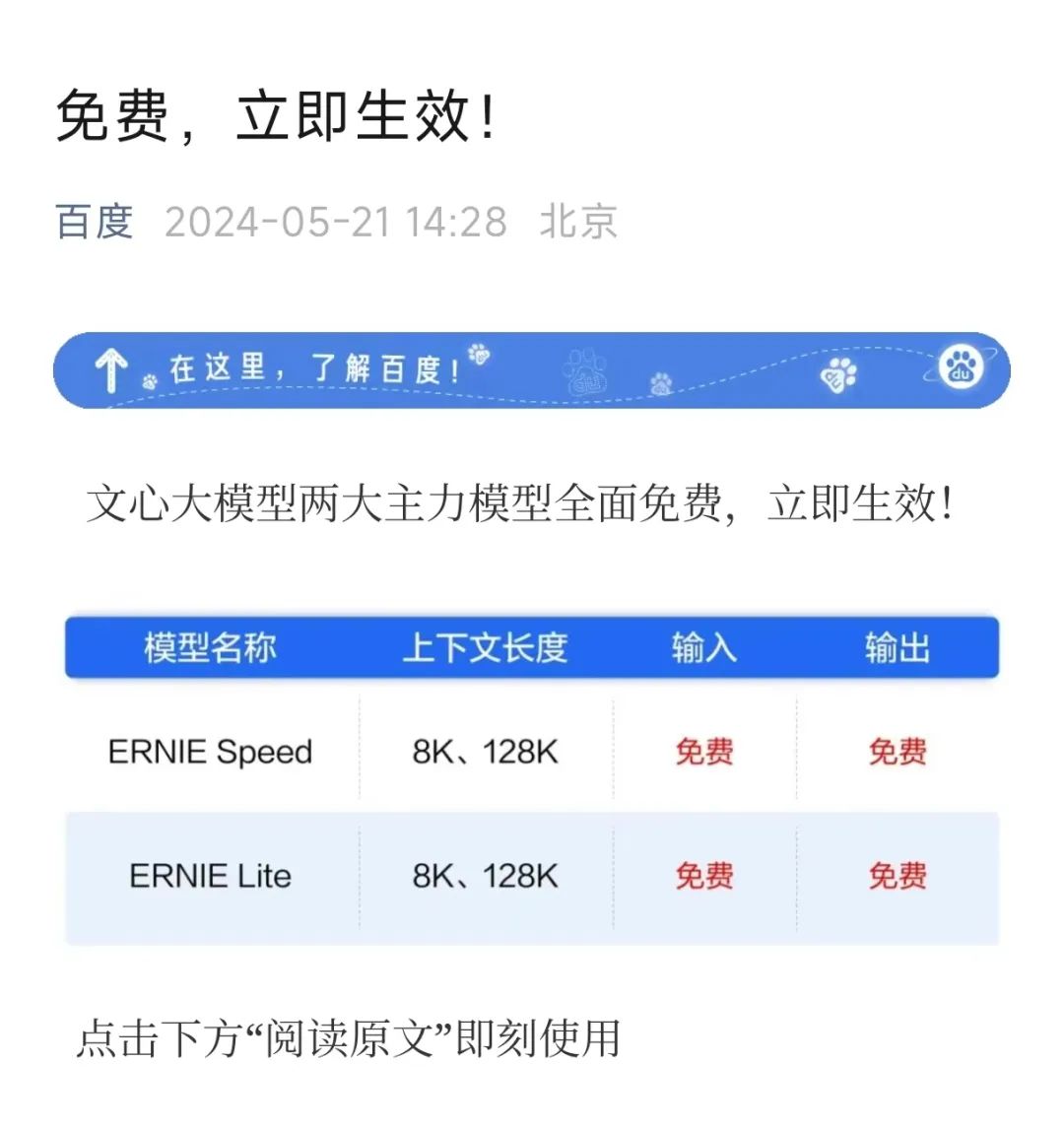

文心大模型直接免费了。

昨天下午,在没有任何预告的情况下,百度突然发布公告称,文心大模型旗下两款主力模型ERNIE Speed、ERNIE Lite开启“零元购”模式。

并且,立刻、马上就能免费使用——简明扼要,模型链接都直接贴在了公告下方。

放出大杀器的,也不只有百度。

在这封公告发布的数小时前,国内大模型赛道另一位头部公司阿里云,方才官宣了旗下通义千问大模型的大幅降价。

今天上午,阿里云官方宣布,通义千问包括Qwen-Turbo、Qwen-Plus和Qwen-Long等9款主力在内的AI大模型全面降价。其中,Qwen-Long API输入价格由0.02元/千tokens降至0.0005元/千tokens,最高降幅达到97%。

阿里更早,百度更狠,大模型赛道集体开卷价格战。

而第一个这么做的,是字节。

5月15日举办的火山引擎原动力大会,字节跳动名为“豆包”的自研大模型正式对外发布。

根据官方介绍,经一年时间的迭代及市场验证,豆包大模型正成为国内使用量最大、应用场景最丰富的大模型之一。目前,豆包大模型日均会处理1200亿Tokens的文本,生成3000万张图片。

最关键的不止这些。

比起屡见不鲜的新模型出现,豆包0.0008元/千Tokens的超低定价直接撼动了行业,大模型由以分计价的时段,一举进入到了以厘计价的区间。

火山引擎总裁谭待称,这个定价“比行业便宜99.3%”,而彼时他背后大屏幕中比较的对象,正是今天几小时内先后降价的文心一言(ERNIE)和通义千问(Qwen)。

一场姗姗来迟的大模型发布,瞬间把压力抛给了赛道内原本领先的老玩家。字节跳动,成为大模型市场那个掀桌子的人。

当然了,随着阿里云和百度的跟进,现在大家又再次来到同一起跑线。

目前,尽管各家大模型在数据上仍有差距,但大模型行业整体由最开始的卷发布速度、参数规模,到现如今卷应用性能、卷市场价格,在过去的两年内事实上都始终居于一种快速迭代且快速变革的状态——AI技术迭代,市场规则变革。

最开始,OpenAI用ChatGPT(GPT3.5)将大模型这一概念引入科技圈并最终扩散到千行百业,其参数规模,在没有具体应用、不能直接看出效果、没有真实案例落地的时期,理所当然成为衡量模型能力的重要指标。

然而,随着技术成熟后逐步落地,单纯的参数规模已不再是评价模型能力的唯一标准。行业开始意识到,模型的结构优化、训练效率和投入产出比,同样重要。

豆包大模型发布当天下午,谭待在群访中同样谈及了成本及市场发展。

谭待称,之所以能给出行业最低的价格,是因为字节在分布式推理、混合调度等技术上有优化成本的手段,并且,未来也能持续以此价格服务行业:“亏损换收入不可持续,我们不会这么做。能力最强的主力模型定价都比行业低,简单来说,是因为我们能做,也需要这么做。”

“做应用一定要生态繁荣,市场面临非常多的不确定性,试错成本要降得非常低,才能够让大家广泛地用起来,不管是大的企业还是说开发的个人,都能用起来,所以市场的呼声就是说我们需要更低成本的核心。”

阿里云方面,阿里云资深副总裁刘伟光对本轮大幅降价的解读,同样为“加速AI应用的爆发。”

在这背后,AI应用已经成为大厂们眼中的新机遇,与新增长。

这事关未来。

根据阿里巴巴最新披露的财报数据,2024年第一季度,阿里云业务收入同比增长3%。在基础模型公司、互联网公司,以及金融服务、汽车等行业客户推动下,AI相关收入实现了三位数的同比增长。

百度公司董事长兼CEO李彦宏,也在业绩会上表示,百度智能云一季度收入为 47 亿人民币,同比增12%,其中生成式AI带来的收入占比6.9%,智能云业务自身实现了盈利。

在保证性能和持续迭代不受成本影响的前提下,大模型行业的头部玩家卷入价格战,不论对于B端还是C端客户来说,都是喜闻乐见。一方面,低价战略降低了用户的使用门槛,另一方面,也迫使其他厂商重新考虑自身的定价策略乃至更系统的成本优化,对于推动整个行业的技术普及和应用落地都是利好。

只是,对于后段无力降本或者暂不具备规模效应的小厂来说,短期的以价换量,也可能就是大浪淘沙的开始。

作者:陶然;编辑:魏晓

原文标题:大模型价格真正“捅穿地心”,字节阿里百度杀疯了!

来源公众号:AI蓝媒汇(ID:lanmeih001),知名AI、互联网产业报道新媒体。

版权声明

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处。如若内容有涉嫌抄袭侵权/违法违规/事实不符,请点击 举报 进行投诉反馈!