让机器像人类一样多模态交互,会是物联网的胜负手吗?

“AI of Things”在等待的,可能不仅是语音交互,而是耳目鼻口耳协同工作的多模态AI交互。

技术这个事情,很多时候不是一蹴而就的。

更多时候,是大家先看到了一个东西非常美好,结果左发展右发展也发展不起来,在吃瓜群众们兴奋地送上一首《凉凉》之后,搞不好哪天却突然一个胜负手抛出来,一切又都不一样了。

曾经的移动通讯、触屏交互莫不如是,今天的3D打印、VR说不定也在重复这个套路。更明显的可能是物联网。这个我们念叨了好多年,虽然也一直在发展,但始终没有大热的技术,到底在等待什么呢?

等待AI?但是音箱刮过一阵语音交互的风潮之后,IoT设备搭载语音控制模块也火了起来。可是直到今天,我们好像发现物联网还是那个物联网,基本没什么变化。

让我们往更深层开个脑洞,“AI of Things”在等待的,可能不仅是语音交互,而是耳目鼻口耳协同工作的多模态AI交互。

你不温柔,我不主动:为什么我们始终远离IoT?

首先我们要搞懂一件事:为什么给设备联网的方案推行了这么多年,我们身边,包括工业和工程领域,真正用到的物联网设备还是没有多少?

答案在于,光给机器设备联网是没用的。你家的桌椅板凳又不想聊微信逛淘宝看快手,它们要网作甚?

人最终需要的是服务,所以设备仅仅联网是没用的,联网之后必须能干点什么才行。这就需要两件事情:

- 人与设备可交互;

- 设备能够感知到人的需求。

在触屏、键盘和手机集成遥控模式,都被证明太麻烦之后,物联网开始把目光投向了能够提供自然交互与感知能力的AI。

机器能够听懂人类说话,并且产生对话并提供服务,似乎某种意义上从源头解决了物联网设备缺乏实际价值的尴尬。于是我们见到了越来越多搭载语音交互平台,能够实现对话的物联网设备。从电视、冰箱到家居设备,再到各种终端不胜枚举。

但实践下来发现,这种模式问题还是不少:比如语言控制不如屏幕控制那么精准,很多时候会误判指令和错误唤醒,比较语言充满了不确定性;再比如,语音交互的物联网设备还是缺乏主动服务的能力,只是换了操作方式而已,用户体验没有本质提升。

仅仅是“能听”,并且还经常听错的物联网设备,就像是两个人谈恋爱,其中一方从来不看你,不会知冷知热、嘘寒问暖,还经常搞错对方的意思,那另一方当然表示我懒得理你…

目前来看,把按钮换成了语音命令平台,隐藏的不确定性太多,而实际价值太少,很难成为物联网爆发的真正依托。

这种“你不温柔我不主动”的人机关系究竟怎么改变呢?

答案也许是让机器能够听和说之外,还要能看,能感觉,甚至能将五感联系到一起进行思考。

感知到交互:机器的五感俱全

所谓“模态modality”,是德国生理学家赫尔姆霍茨提出一种生物学概念。即生物凭借感知器官与经验来接受信息的通道,比如人类有视觉模态、听觉模态等等。

后来这个概念引申到人文科学领域,成为哲学和文学上的一种话语批评方式;而来到机器人和计算机科学领域,就成了机器与物理世界联系的通道。

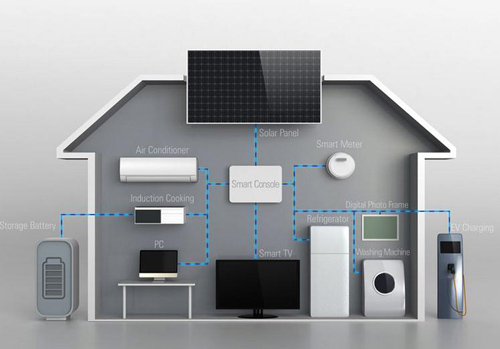

假如我们把“模态”通俗地理解为感官,那么智能音箱就是只具备听觉模态的物联网设备,而加载AI分析能力的摄像头可以视为视觉模态的物联网设备。把听觉、视觉甚至更多模态组合到一起,多模态物联网也就诞生了。

事实上,在AI研究当中多模态转换是非常普遍的课题。比如一个很出名的AI研究方向是让智能体根据看到的某张图片来生成文字(也有看到文字生成图片和视频的),这就是让AI模型完成在视觉和语义之间的模态转换。

运用到物联网设备当中,今天主要的AI感知模态有三种:

- 语音交互,包括语音指令控制、语义理解、多轮对话、NLP、语音精准识别等领域;

- 机器视觉,包括自然物体识别、人脸识别、肢体动作识别等;

- 传感器智能,包括AI对热量、红外捕捉信号、空间信号的阅读与理解。

把这三种东西融合在一起,物联网设备就可以在单纯的能听会说之外,同时还用摄像头观察、用传感器判断。而比较前沿的多模态感知研究当中,还包括机器嗅觉,机器触觉和情绪理解等内容。

我们在等待的下一代物联网设备,很可能诀窍就是把这些模态给揉在一起,完成从多模态感知到多模态交互的体验。用一句我们十分熟悉的话说,就是要让机器身上的五感“生态化反”…

今天让人乐观的多模态交互型IoT

又能听,又能看,又有传感器的设备,听上去似乎有点过分乐观了。但好在综合了较多采访与观察之后,我们发现今年确实是值得为多模态物联网设备乐观一下的时候。

可以看到,很多双模态交互,甚至多模态混合交互的解决方案都在从实验室里走出来,甚至已经可以在我们生活中看到。这些解决方案更重要价值是作为案例,可以让更多企业、开发者和垂直行业看到多模态物联网的可复制价值。

举例来说,离我们最近的多模态AI交互技术投射在物联网设备上,大概就是用机器视觉技术进行嘴唇识别,来分离语音交互指令。我们可以看到很多实验室和科技公司,都在尝试用机器视觉来读取说话人的唇语和动作,从而判断每个声音指令的来源。

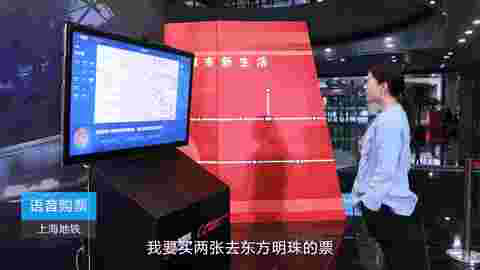

这种技术已经在国内被运用到地铁售票解决方案中,通过机器视觉来识别买票人,从而在地铁站的嘈杂环境中完成语音售票。

另一个我们能看到的例子是空调。在一些新的智能空调解决方案中,空调会在语音交互的基础上通过机器视觉来判断用户的位置,提供智能送冷,并且会结合传感器判断屋内温度和湿度,提供更精准的环境方案。

同样是在家电上,今年电视背后的AI平台战打得风生水起,把机器视觉技术引入电视成为了新的趋势。通过机器视觉来让电视观察屋内照明情况、用户与电视的距离,电视可以主动调节屏幕光线强度,输出比较护眼的模式。还有的AI应用是让电视在观察到儿童看电视后主动开启童锁。

在日常生活之外,多模态交互设备也在应用于工业设备中。比如通过给机器设备搭载机器视觉+传感器提供安全警告,以及利用机器视觉+故障信号的方式判断设备问题等。

把不同信号模态整合在一起,实现设备的多维感知,今天正在以比较快的速度来到应用市场。

高精度判断用户命令,输出主动服务;提供实时化、弹性化的体验,可以说是AI带来的多模态交互技术放进物联网世界中的一张鬼牌。

当然了,还是有几道难关…

按照惯例,最后我们还是要正视任何技术都存在不足。刚刚有一点萌芽的多模态交互+物联网当然也不例外。

最核心的一个问题,是我们到底靠什么实现多模态协同?

目前来看,无论是家电还是工业设备,实现多模态混合的主要方式还是把不同的传感源输入到设备处理中心,启动一定程序来开启相应服务。

换句话说,AI模型本身是没法理解多模态信号的,只是不同的算法启动不同的开关而已。这种“伪AI多模态”的设备也不是不行,只是在实时化和复杂的推理判断上会有心无力。

解决方案可能是一种叫做“多模态深度学习”的技术,让AI智能体本身能够理解多模态信号,从算法本身就容纳听觉、视觉、传感信号进行统一思考。这样可以保证设备高度实时化,并且可以让设备进行多模态协同学习,真正地“聪明”起来。

这要求在算法上对多维度数据的各自表示、融合、对齐有新的突破,今天我们还只能等待学术界的好消息。

另外一个问题,是今天的多模态交互缺少有效的开发平台,开发者和企业很难复制这一模式,来进行独立的物联网解决方案开发。当然,目前来看这应该仅仅是个时间问题。

与之相对应的,是在缺乏行业标准、开发基础的前提下,今天开发一个多模态物联网项目需要大量的人才成本和综合开发成本。并且缺少芯片、专用传感器等后端硬件的支撑。这个领域国内有一些芯片和算法公司,但似乎大部分处在做PPT的画饼阶段。

综合来看,AI带来的多模态想象力,大概确实可以完成一些物联网很早就希望实现的东西。但方兴未艾的产业局势,还需要巨头搭建平台、优质案例出现、开发者路径明确等几个环节才能开启下一轮风口。

但无论如何,耳聪目明的机器,已经在跑步过来的路上了……

作者 @脑极体 。

关键字:多模态交互, 机器人, 物联网

版权声明

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处。如若内容有涉嫌抄袭侵权/违法违规/事实不符,请点击 举报 进行投诉反馈!