全球社交媒体大转型

一场全球社交媒体大转型运动,正在进行。

这场转型运动的核心关乎平台内容治理,始自2018年。悉数这一年的代表性事件,“剑桥分析”无法避开。

2018年3月,Facebook承认,英国数据分析公司剑桥分析在2016年美国总统大选前违规获得五千万用户信息。而后Facebook因未能妥善保护用户个人敏感信息等被集体诉讼,同时,美国联邦贸易(FTC)也对Facebook展开调查。而马克·扎克伯克本人,也因剑桥分析事件出席美参议院委员会听证会,接受议员问询。

无论“剑桥分析”是不是导火索,但从2018年起,治理内容生态,就开始成为大部分社交媒体的核心工作。

社交媒体上的有害内容一般包括不实信息、仇恨言论和儿童色情等。在这场转型运动中,Facebook、Instagram等社交媒体,增设了多种功能以提升内容治理能力、对抗有害内容。这既是平台承担社会责任的体现,某种程度上,也是对监管力量和舆论质疑的回应。

一、对抗不实消息

“全球变暖只是谎言”“新冠病毒是人造的”……对于这类社交媒体上的不实信息,多数人已经司空见惯。

除了传统的凭空捏造或以讹传讹的虚假信息(misinformation),如今社交媒体上还涌现出大量的误导性信息(disinformation)。这类不实信息往往基于政治或商业目的,掺杂某些真实的信息,从而实现更强的迷惑性,无论是平台算法,还是普通用户,都更难鉴别。

作为应对,全球最大的社交媒体Facebook自2016年发起事实核查计划,至今已与全球范围内的80多家独立第三方核查机构合作。每当事实核查机构将平台上的一条内容评定为“虚假”时,Facebook会大幅减少该内容的传播,以降低其曝光率。

2021年5月,Facebook进一步推出系列措施以治理不实信息。此前,当事实核查机构认为某条帖子是不实信息后,转发过的用户将会收到提醒,Facebook优化了这一机制。如今,用户可以查看事实核查机构评估该信息失实的理由,已经转发的不实信息也会被加上标签,提醒其他用户这是不实信息。Facebook还会警告用户,如果多次散播不实信息,他们的帖子将会更少地出现在其他用户的信息流中。

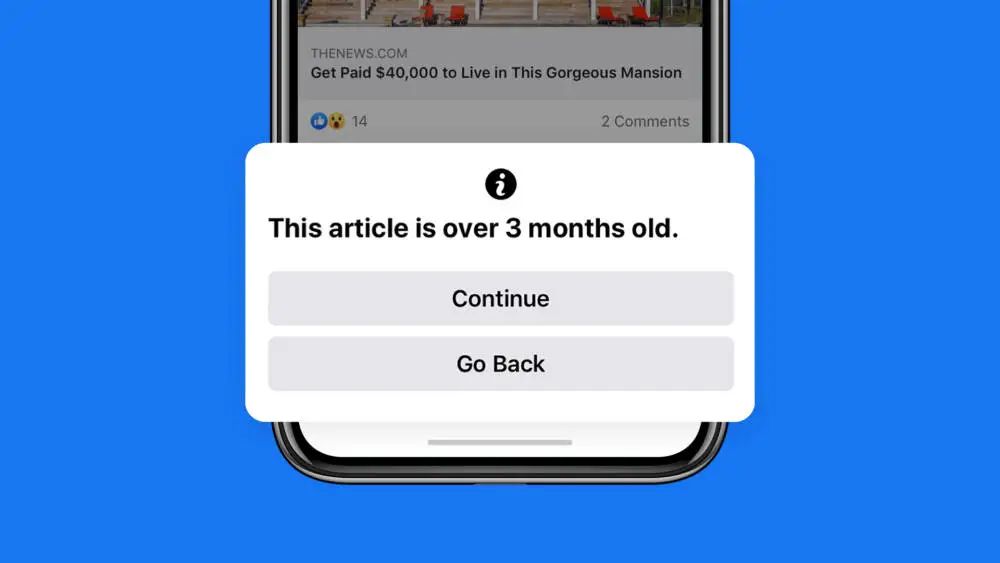

许多用户在Facebook上获取新闻资讯并进行讨论,但有一些用户会重新分享过去的新闻信息或帖子,并将其作为新的信息,而这可能会传播错误信息,或者让人对新近发生的事实产生误解。针对这一问题,Facebook增设了一个警告的弹窗,当用户想要分享的内容的发布时间超过90天时,就会收到提醒。

此外,有许多用户往往并没有阅读文章内容,而是在看到某个文章的标题后就转发。这可能散播不实信息,并且仅仅依据标题就与他人展开讨论,可能没有什么意义。为了让用户更加负责任地转发信息,Facebook会提醒那些没点开链接就按下“转发”按钮的用户:你将要分享你没有阅读的文章,这可能意味着在关键事实上犯错。

实际上,早在2020年6月,Twitter就在其安卓客户端试行了这一功能。Twitter产品总监Kayvon Beykpour表示[1]:

“在Twitter上,链接或者文章很容易被疯转,这可能产生强大的影响,但有时这是危险的,特别是当用户没有阅读他们所传播的内容时。这项功能鼓励用户在转发之前点击链接并阅读文章。”

试行三个月后,Twitter表示,用户在看到提示后打开文章的次数增加了40%,在转发前打开文章的次数增加了33%。有些用户在打开文章后最终没有转发,说明阅读文章的确能让用户更谨慎地决定要不要转发。

疫情背景下,社交媒体上涌现了大量与疫情相关的不实信息,造成恶劣影响,比如宣称接种疫苗会得癌症的“反疫苗运动”。早在2020年2月,世界卫生组织在新冠肺炎疫情报告中就特别提到,疫情的暴发会引发一场大规模的“信息流行病(Information epidemic)”,即在一些事实中混入恐惧、猜测和流言,这些不实信息可能会在世界范围内迅速传播,影响全球经济、政治与安全。

Facebook也针对疫情相关的不实信息推出了治理措施。在用户准备分享疫情相关链接时,将会跳出一个通知,这一通知会展示相关内容的发布时间和来源,并附有Facebook的“COVID-19信息中心”链接,让用户能够更方便地获取权威的关于疫情的可靠信息。不过,用户在转发政府卫生部门和全球卫生组织(如世界卫生组织)发布的内容时将不会出现这个通知,以避免减缓可信的卫生部门的信息传播速度。

此外,Facebook的算法系统将会删除被医疗专家标记为失实的疫情相关信息,从疫情暴发到2021年4月,Facebook就删除超过1200万条和新冠疫情或疫苗相关的不实信息。[2]

二、治理仇恨言论

除了虚假信息,如何治理仇恨言论,也是社交媒体平台面临的一个棘手问题。根据Meta(Facebook于2021年改名为Meta,旗下包括Facebook和Instagram等产品)的定义,仇恨言论包括暴力或非人性(dehumanizing)的言论、低劣的声明、呼吁基于某些特征而排斥他人,这些特征包括种族、宗教信仰、性取向、性别和疾病等。[3]

Instagram在2021年增设了一系列功能以治理仇恨言论。其中有一个功能被命名为“limits”,当用户启用后,系统会自动隐藏来自不关注你的人,或最近才关注你的人的评论和私信请求。

根据Instagram的说法,开发这个功能是因为创作者和公众人物会收到大量来自他们不认识的人的评论和私信,其中可能含有大量的垃圾或谩骂信息。但是许多用户又不想完全关闭评论和私信功能,仍然希望与粉丝互动联系,因此可以限制那些不是粉丝或最近才成为粉丝的人发布评论和私信。

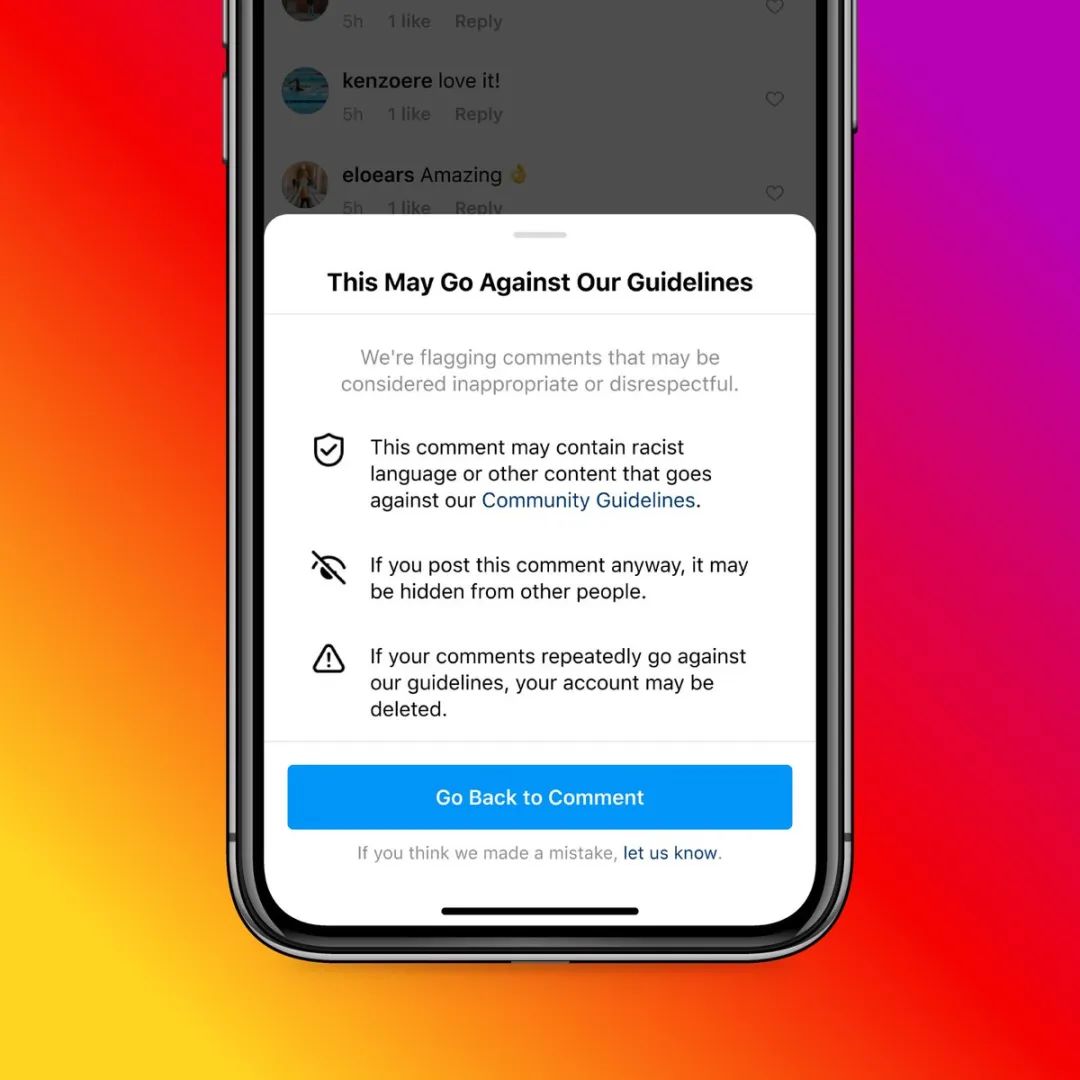

当有用户试图发表攻击性评论时,Instagram也会显示警告提醒:如果他们坚持发布,他们的评论可能会被删除或者隐藏。Instagram发现这些警告的确能够阻止用户发布攻击性言论。根据统计,在一周的时间内,Instagram平均每天显示约一百万次警告,在大约50%的时间里,用户根据这些警告重新编辑或删除了评论。

网络暴力行为的产生,多是由于情绪驱动的“一时之快”,尽管一个警告提示并不能真正阻止用户发布恶意言论,但它让发表评论多了一个步骤,减少了因冲动而言语攻击他人的可能。

此外,Instagram还推出了一个叫“Hidden Words”的功能,开启这一功能后,系统可以自动过滤攻击性词语和emoji,并将其收集到隐藏文件夹中,用户可以自己选择是否要查看这一文件夹。这一功能也可以帮助用户过滤那些可能是垃圾邮件或低质量的私信请求。Instagram表示,将持续更新扩大自动过滤的攻击性言论、主题标签(hashtag)和emoji的清单。

三、内容治理的难度

内容治理已经成为全球共识,无论是各国政府、公众抑或是社交媒体本身,都认为有必要处理平台上的假新闻和仇恨言论等有害信息。

但是,处理有害信息之前,首先需要确定哪些信息属于有害信息。这并非易事,有时还存在巨大争议。

例如,讽刺性的信息和攻击谩骂的区别是什么?名人转发假新闻和普通人转发假新闻是否需要区别对待?这些问题相当棘手。即便是儿童色情这种全球公认要审核删除的信息,也存在模糊地带。

2016年,挪威作家Tom Egeland在Facebook上传了一张经典的越南战争照片,照片中一个赤身裸体的女童在哭着逃难,Facebook随后删除了这张照片,引起轩然大波。在强烈的公众呼吁之下,Facebook后来又恢复了这张照片。

2020年,Facebook成立了一个监督委员会(Oversight Board),这一委员会将独立审理具有代表性的平台内容审核案例,决定哪些信息是违规需要删除处理的,哪些信息又是可以公开传播的。

这一监督委员会的成员背景多元,包括来自多个国家的法学教授和政府高官等。用户可以直接向这个监督委员会投诉,Facebook也可以直接向委员会提交具体案件。该委员会审理的最著名的案件,莫过于特朗普账号被封禁一案。

尽管欧美舆论对Facebook等社交媒体口诛笔伐,但这些社交媒体已经在欧美地区提供了远优于其他地区的服务。西方的社交媒体在非洲、中东和南亚等地区虽然有大量的用户,但并没有实现与欧美地区同等质量的监管力度。

2021年,Facebook前数据科学家弗朗西斯·霍根(Frances Haugen),向美国证券交易委员会和《华尔街日报》披露上万份Facebook内部文件。文件显示,Facebook已经意识到自身在全球许多较为落后的国家没有承担足够的责任。

美国以外的用户占Facebook总用户数的90%以上,但负责内容治理的工作人员,只有13%的时间花在这些地区上。Facebook服务于全球160多种语言的使用者,但其仅研发了针对英语等欧美主流语言的内容审核系统,这意味着其余很多语言的违规内容难以被系统识别和删除。

例如在2020年底,Facebook的一份内部报告显示,Instagram上只有6%的阿拉伯语仇恨内容能够被系统试别;另一份报告则显示,30天内在阿富汗发布的仇恨言论中,仅有0.23%被Facebook的系统自动删除[4]。

为了应对欧美政府和媒体施加的压力,Facebook等社交媒体持续推出各项内容治理措施,但这些措施也是地区性的。Facebook内部清楚知晓自己的产品在非洲和中东等地被用于传播极端言论、人口贩卖、种族清洗等,但并没有付出相对应的治理力度。

不过,仅凭Facebook等社交媒体自身的努力,的确也难以应对全球涉及如此之多语言、民族和宗教的问题。

技术发展给内容治理带来了更大的挑战。实际上,即便对有害信息存在明确的标准,即使平台有着强烈的治理决心,通过人工或技术手段甄别有害信息的难度也不低。

如今社交媒体上的许多内容,并不是真实的用户创造发布的,而是由虚假账号批量制造生产。这些虚假账号又被称为社交机器人(social bots),它们可以通过算法自动发布内容并与其他账号互动。这意味着,有些账号虽然没有散播不实信息,但因为这些账号本身是虚假的,是被用来从事宣传的,也需要被处理。

有研究发现,2016年美国大选第二场辩论中,Twitter上亲特朗普的2400万多条推文有三分之一由社交机器人发出,支持希拉里的72000条推文中,社交机器人生产的内容占四分之一。[5]

社交机器人还会随着社交媒体上的重大事件更替,删除其先前的推文、改变显示用户名后以新面目出现。尽管Twitter和Facebook大力打击虚假账号,但虚假账号依然泛滥。在近来伊隆·马斯克暂停收购Twitter事件中,虚假账号数量就成为了焦点。

在内容治理方面,社交媒体也不断面临新的问题。比如在虚假账号之外,深度伪造等技术给内容治理带来更大的挑战。这意味着,大量的有害信息有着以假乱真的效果,并且这些有害信息的生产者不是用户,劝阻用户的举措仅仅能起到减缓有害信息传播的作用。提升内容治理水平,需要社交媒体开发更先进的技术,魔高一尺,更需道高一丈。

四、无法退回的昨日世界

Facebook于2004年上线,至今仍然未满20年。在这十数年间,社交媒体让地球村成为了现实,让人们得以与在现实中永远不会相识的陌生人交流。

社交媒体发展初期,人们欢呼于社交媒体如何降低公共领域的表达门槛,人人都有麦克风。但近年来,无论是关于仇恨言论、虚假信息泛滥的担忧,还是针对信息茧房、群体极化的警惕,都体现了人们逐渐发现并试图理解社交媒体的负面效应。

内容治理已经成为社交媒体不得不直面的问题。回头看,这场全球社交媒体的转型运动,就始于对这种压力的回应。

显然,我们永远无法退回没有社交媒体的世界。如果未来不存在社交媒体,那也只可能是出现一种更有吸引力的替代品。如今我们只能着眼于最小化社交媒体的负面影响,探讨如何在技术和产品层面改进社交媒体,如何明晰内容治理的边界,这将是一个漫长的过程,更需要像此前高速发展期去研究用户需求一样,不断改善社交媒体的功能与用户体验,创造更友善的社交媒体环境。或许这才是这场“转型运动”的最大意义。

引用/注释:

[1]https://twitter.com/kayvz/status/1270788548002631681

[2]https://www.facebook.com/business/news/how-facebook-addresses-covid-19-misinformation

[3]https://transparency.fb.com/data/community-standards-enforcement/hate-speech/facebook/

[4]https://www.theatlantic.com/ideas/archive/2021/10/facebook-failed-the-world/620479/

[5]Stieglitz, S., Brachten, F., Berthelé, D., Schlaus, M., Venetopoulou, C., & Veutgen, D. (2017). Do Social Bots (Still) Act Different to Humans? – Comparing Metrics of Social Bots with Those of Humans. HCI.

作者:梁晓健 王健飞,编辑:王焕超,来源公众号:波动刻度

原文链接:https://mp.weixin.qq.com/s/KxbFfsiRdjqwJ4AdxBryXw

本文作者@波动刻度 。

版权声明

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处。如若内容有涉嫌抄袭侵权/违法违规/事实不符,请点击 举报 进行投诉反馈!