十问Chat:关于LUI,你知道多少?

从ChatGPT开始到现在,似乎我们默认了所谓的LUI(Language User Interface),不过黄叔从来没有觉得这是应该的,也随着对于AI产品研究的逐渐深入,在5月份情感陪伴这篇文章,就清晰的指出:

大部分人被ChatGPT和C.ai骗了!

那今天,我们进一步阐述Chat这种LUI形态是如何的“反人类”,更多是提出问题,也给出当前的一些解决方案,希望能为从业者们提供一些灵感,欢迎大家互通有无。

有位朋友总结的挺好的:“Chat更像是早期寻找PMF的交互形态, 给人旷野而非轨道。”希望大家能更好的找到自己的轨道:)

Q1:Chat对话的自然性和信息效率之间存在矛盾?

我们都知道目前的AI产品大部分很容易遇到天花板问题,比如Kimi的增长已经非常明显卡住了:

这背后当然存在多个层面的因素影响了,但AI应用至少在国内,我们能很明显看到还处在一个早期阶段,有一点很明显的是:

Chat对话是很自然的,很符合日常交流的,但是和信息的效率(包含输入和获取)之间,似乎存在很大的矛盾。

这是一个很大的话题,作为本篇文章的起始,后面黄叔会尝试从多个角度抛砖引玉:文字是线性的!Prompt的存在就是逆天开放性vs目标导向文字输入vs多模态输入不适合用Chat的形态文字输出vs多模态输出用户认知和预期管理问题个性化和定制化能力不足大家都被ChatGPT和Cai骗了

Q2:文字是线性的。。。

平克说过非常有名的一段话:

写作之难,在于将网状的思想,通过树状的句法,用线性的文字展开

我们大脑中有无数碎片化的想法,你要找到一条最佳的文字线串起来,这件事情对于人类来说,是普遍非常难的,所以在搜索这个人类最大的输入框里,大量的Query都是短词。

如果无法用文字清晰的表达自己究竟想要的是什么,意味着Chat形态不是老百姓最好的和AI交互的形态。

这里还会有进一步的影响:认知负荷和互动深度。

一个是用户在上下文中,自己就需要记住之前的对话内容,这增加了认知负担,另一个是线性文字限制了互动的深度和广度,难以实现复杂的交互和多层次的信息传递。

Q3:Chat需要Prompt功能才能获得好结果?

Prompt是什么?Prompt是Chat交互形态下自然长出来的一个玩意。

Andrej Karpathy在2023年5月,微软build大会上,分享过《State of GPT》,其中具体说了Prompt是人类语言和机器语言之间的桥梁,我们需要用Prompt来弥补人类思维与机器处理方式之间的差异。

这也是因为大模型本身就基于海量的数据做的训练,你需要更加细致的描述,才能让它知道你具体需要什么。

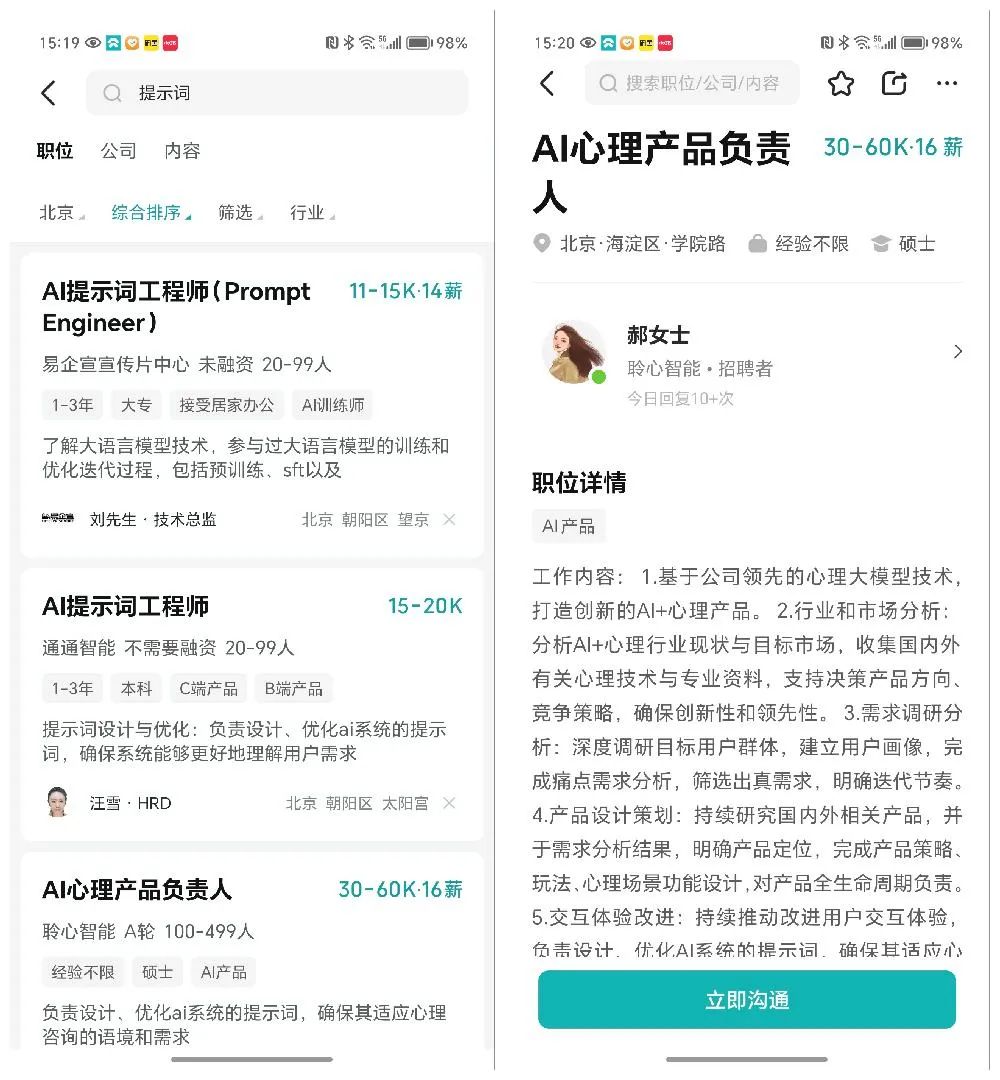

对应的,用户如果希望获得更高质量的AI生成的内容,也需要输入更高质量的Prompt,现在你理解为何会有提示词工程师这么一个职业存在的原因了吧:

Q4:在 Chat 对话中融入 GUI元素是否可行?

既然输入那么难,那么能不能在Chat对话中融入GUI元素?

举一个具体例子大家可以更清晰的理解,比如你去看病,医生肯定会问一些关键信息,但会问你哪些关键信息其实是背后大量的诊疗经验,以及基于望闻问切,甚至是病历做出的,这个过程,用一个对你过去信息知道不多的大模型来多轮对话,显然效率很低,在夸克浏览器里,我们就看到一个不错的案例:

这个就是GUI(GUI是”Graphical User Interface”的缩写,中文通常翻译为”图形用户界面”)比起LUI的好处:

GUI是点击操作,可以触发预置好的信息,关键在【预置】,用选择代替输入,效率上比Chat高很多倍。 (from @杜昭)

有和夸克的同学交流过,AI健康问答这个场景,也是他们着重发力的,拿了大量的数据以及找了专业的医生团队做了验证后,抽象出来的补充信息模块。

另外,即刻上的@申悦 也给了个案例,智谱的智能体里,输入也增加了表单,可以更方便的用户知道应该输入什么信息:

可以看到,GUI对于Chat的开放性是有很好的约束作用的,面对空白的输入框,用户很容易发懵:“我到底应该输入啥才能获得好答案?”,GUI限定条件后,用户能更明确一些。

Q5:除了文字输入,还有哪些更便捷、高效的输入方式能够应用于 Chat 对话,以降低用户的表达门槛?

有很多方式,不是所有的方式都依赖于文字输入。

我们在情感陪伴一文的总结中,提到了情感陪伴实际上是内容消费的逻辑,那对应的,抖音是一种上下滑和双击屏幕就能完成的轻互动内容消费产品,那AI生成的内容产品里,如何借用呢?

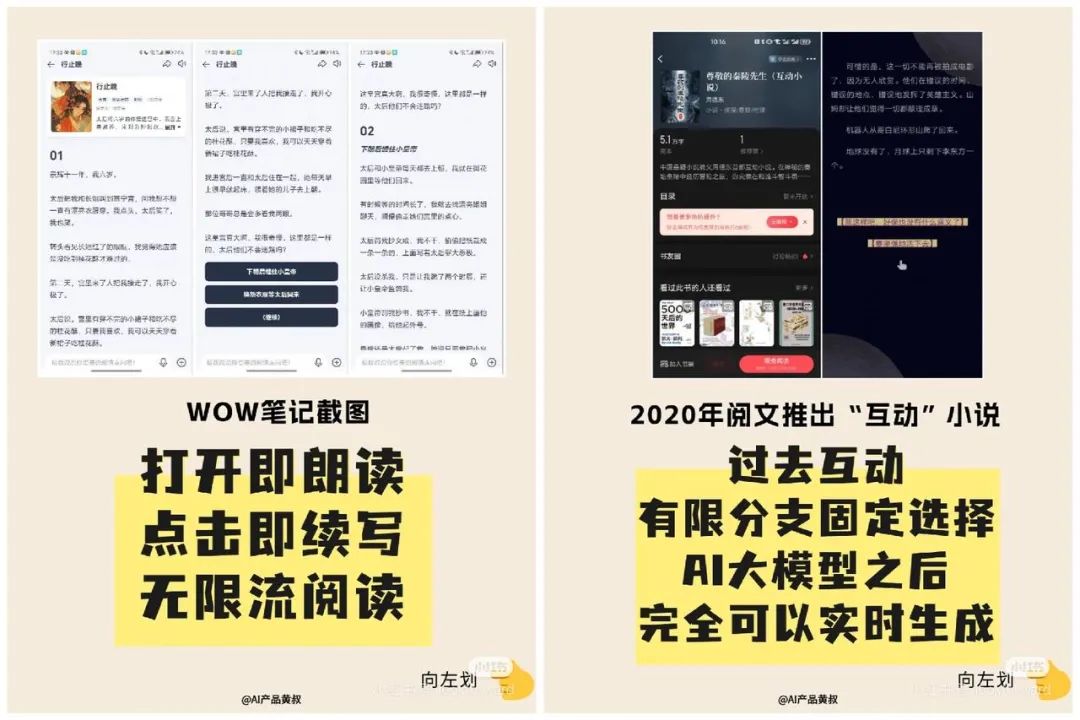

美团WOW的互动故事就提供了一种可能性,AI先生成一个章节,然后给出选项用户点击选择(也可以手动输入),AI继续生成,循环如此:

除了上面这种,最典型的就是语音输入,甚至是实时语音互动,最为典型的就是GPT-4o,非常炸裂的发布会我们都看到了,300ms以内的低时延,击穿了“实时性”这个人类能感知到的节点。

大量的AI助手,也强依赖于语音交互,典型的比如Siri、小爱同学,车机上的“理想同学”“Nomi”等等。

当然难度也是语音识别的准确性,以及环境噪音、用户有口音,以及用户输入意愿度的问题,特别是语音交互里,长文本的对话就不现实了,比如MiniMax的海螺AI,当打开实时语音对话时,AI的人设就会变成倾向于短回答来保证交互效率。

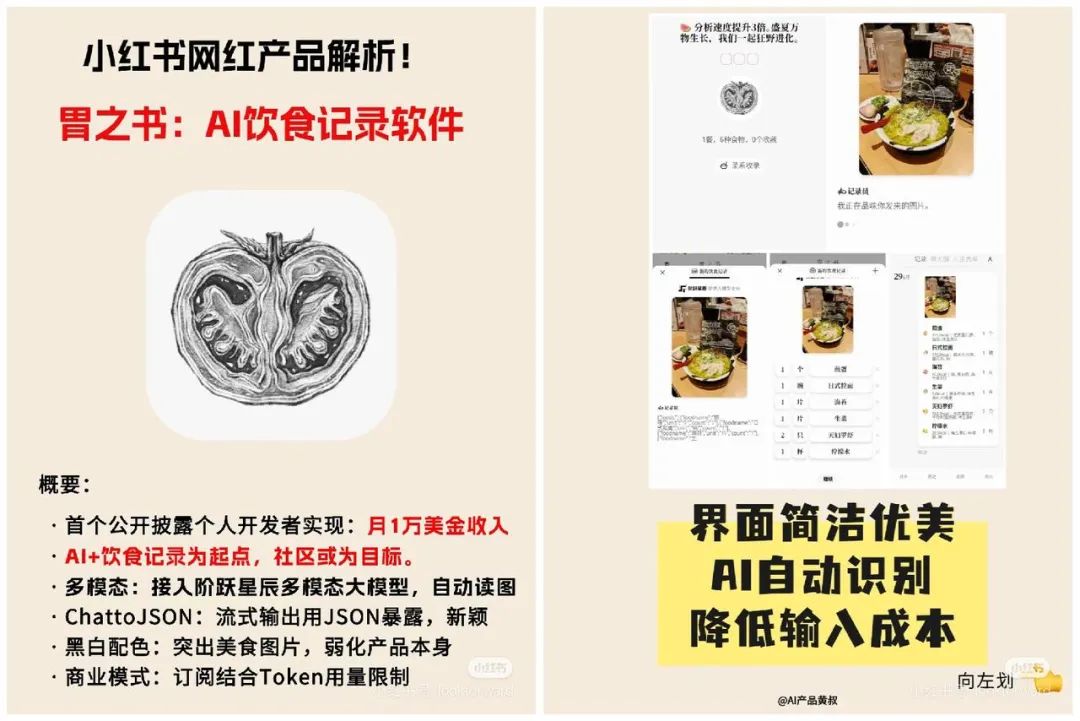

除此之外,图片、视频输入更为典型,图片输入比如前阵子的网红应用胃之书:

它的输入并不需要输入文字,点击拍照,然后大模型就会自动解析,几乎全自动的完成了录入。

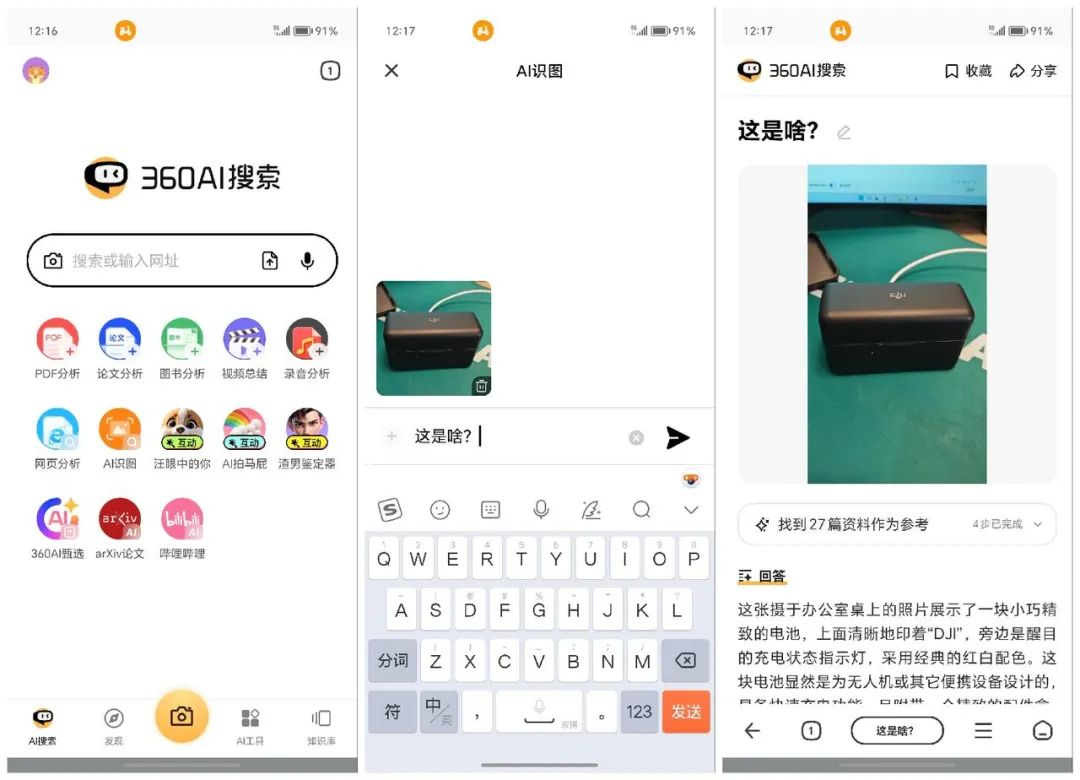

再比如360AI搜索,增加了拍照上传功能:

更经典的解决方案是雷鹏眼镜,在镜框上面增加摄像头,真正做到了所见即所得,用“Hi,meta”作为唤醒词即可调用AI完成交互:

所以,AI眼镜是蛮有未来机会的一种新硬件载体。

Q6:有不适合用Chat的形态么?

很典型的,Notion AI推出之后,大家也更能理解对于写作,inline非常重要,即:在文本中间整合加入AI能力,才能更有效的帮助用户完成创作:

同样是文字处理,但是直接在内容里嵌入AI能力,并且点选即可完成,这种效率似乎提高了不是一星半点。

当然,Notion AI同样加入了Copilot,用对话来帮助用户更好的使用更多AI能力。

这种呢,就是比较复杂的文字处理,不便于在Chat线性的交互形态里完成,所以需要inline的逻辑来做,对应的,我们可以引申一下:

- 复杂的数据分析和可视化(Excel等)

- 长篇文档编辑和排版(Notion AI)

- 实时协作和团队沟通高度专业化的技术开发(Github Copilot)

- 设计和创意工作(视频工作流单纯的Chat不好做)

- 教育和培训(高度互动的教学)

Q7:AI除了输出文字,不能输出其他形态的内容么?

ChatGPT诞生至今,大量的ChatBot都以文字输入输出为核心,这也导致我们在上一篇《十问AI搜索》中提出一个问题:

AI搜索是一种退化?结论:搜索从10个链接到1个答案是进化,但从视频到文字是退化

我们可以看一下抖音的AI搜索,如上~

抖音的日活达到7个亿以后,我相信已经有非常多所谓下沉市场的用户在使用了,他们已经非常的习惯于刷短视频来获取信息了,那上面的文字版本的抖音AI搜索是不是一种所谓的倒退呢?或许用户在看到抖音里出现大片段文字的时候,会直接关掉。

交叉对比,我有和小红书的运营交流过,小红书其实鼓励我多去发图文笔记,因为一二线的用户对于图文笔记的吸收效率是最快的,想想图文笔记的结构化和信息提取速度,一目十行,可以非常快的就理解到你表达的意思。但是视频内容其实就更加的线性,只能随着视频内容的按时间展开:

两者结合,会发现一个有意思的现象:

- 一二线城市受过高等教育的用户更容易接受图文结构化的信息;

- 三四线城市/农村的用户,只能接受视频信息。

这也意味着,AI产品想要突破当前的圈层,势必要延展出去,有更多模态的内容呈现,才能让用户更加容易吸收。

我们会发现很多产品开始逐渐增加对多模态的支持,比如Genspark重新组织了Sparkpage在内容形式的组织上,比如一些AI游戏,把AI融入到游戏中的尝试,都非常的有趣。比如百川也做了碟镜Dreamland:

还有AiPPT类内容的组织,也很好的实现了Query to PPT方式的形态,比如做得很好的Gamma:

这块随着技术的成熟也会逐渐开始发展起来,值得期待。

除了上面输入输出方面的的问题之外,还有下面的问题:

Q8:用户认知和预期管理问题?

ChatBot形式的交互界面,很容易让用户高估 AI 的理解和解决问题的能力。

那我自己举例子,作为一名蔚来车主,在看到蔚来宣传Nomi接入大模型,升级为NomiGPT后,就尝试做一些交流,但会发现很多问题给的答案都很差,就会默认觉得NomiGPT不行,下意识的会拒绝使用。

其实作为车机里的GPT,应该非常清晰的给出一些关键指引,比如用车相关,车控相关,这样更容易让用户找到Good Case,而不是面面俱到,很容易就遇到Bad Case,宣传角色扮演、树洞情感陪伴,这种非常不好。

假如说1000万次的总聊天互动次数,那角色扮演和情感陪伴只占到总数的千分之二三,并且这两点其实最先进的大模型都满足的不好,何况一个接入了国产大模型的Nomi。

这背后就涉及到,要明确产品定位和功能边界: 让用户清楚地知道 AI 产品能做什么,不能做什么。同时加强用户的引导,再不断提高用户常见Query的效果。

Q9:个性化和定制化能力不足?

既然是Chat,用户会把AI当成某个角色在脑海中进行演绎,但目前许多 Chatbot 产品就像流水线生产的“标准化”机器人,缺乏“个性”和“温度”,无法满足用户对独特体验的需求。

比如,很多 Chatbot 的语言风格过于机械、生硬,缺乏情感和个性,无法与用户建立情感连接。用户难以感知到 Chatbot 的“人设”,更像是在与一个冰冷的机器对话。

比如,理想情况下,Chatbot 应该像一个贴心的朋友一样,记住用户的喜好和习惯,提供更加个性化的服务。但现实是,很多 Chatbot 缺乏记忆能力,无法根据用户的历史行为和偏好进行个性化推荐或服务。

能部分做到这一点的,拿到了OpenAI投资的Dot,在即刻已经发现一些朋友对这款产品极度的喜爱:

当然,受限于前面说的几个问题,也会影响它被大众接受的广泛度。

再比如,很多 Chatbot 产品的功能和服务都是固定的,用户无法根据自己的需求进行定制化设置。例如,用户无法选择 Chatbot 的语言风格、对话主题、信息推送频率等。

还有,很多 Chatbot 产品的设计目标是服务于大众用户,缺乏对特定场景和用户群体的针对性设计。例如,面向老年人的 Chatbot 产品应该是什么样的?或者说并不需要一个ChatBot,而是一个人形机器人?

总而言之,个性化和定制化是 Chatbot 产品未来发展的重要方向。

Q10:大家都被ChatGPT和Character.ai骗了?

这个问题的核心在于,ChatGPT和Character.ai等聊天型AI产品是否在某种程度上误导了用户对AI的期望和认知。

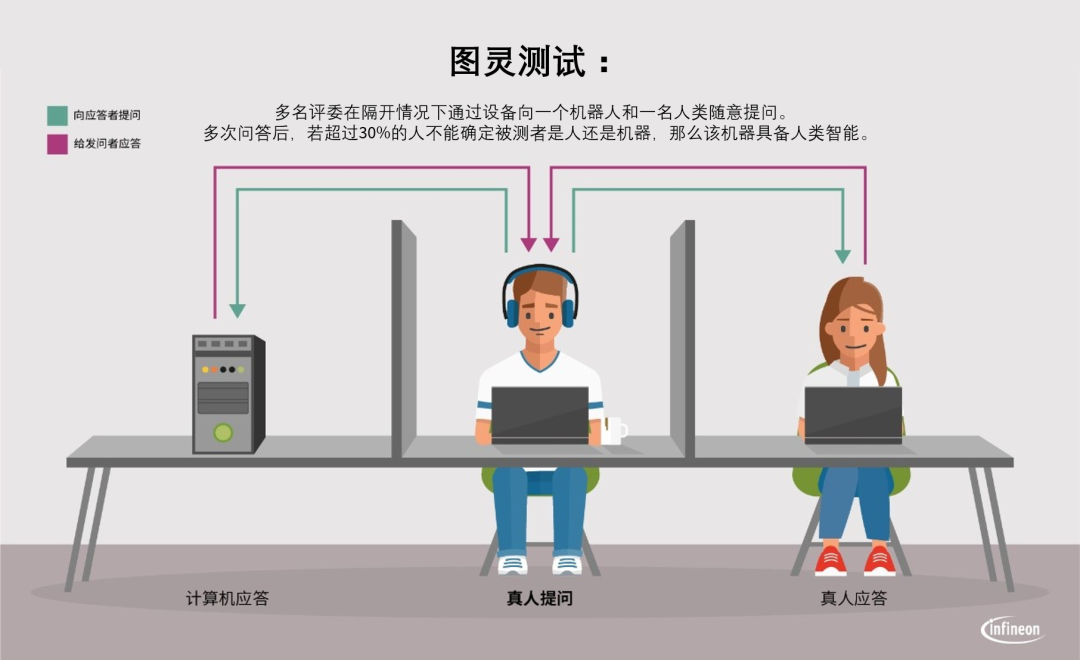

首先,Chat这种形态的引入,还是把AI模拟成了人类,从图灵测试开始,似乎大家对于AI就有了这种感性的认知,似乎Chat是必然的智能表现的形态:

特别是ChatGPT和Character.ai流畅的对话能力,给用户带来了高度智能的错觉。

所谓的LUI范式出现了。对应的问题一直没有答案:

LUI是不是符合用户需求的最佳范式?

没有答案,大家都一直在探索,个人认为,LLM的智能,只用Chat来表达是非常狭隘的,随着GPT4o和Gemini 1.5的多模态能力出现,我们也发现了GPT5迟迟无法发布的前提下,大模型仍然在进化,也出现了更多的应用落地可能性。

把思考抽出来,重新理解Chat的局限,也有助于我们更好的设计产品。

作者:Super黄一起不断迭代,个人公众号:Super黄的念想

版权声明

本文来自互联网用户投稿,文章观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如若转载,请注明出处。如若内容有涉嫌抄袭侵权/违法违规/事实不符,请点击 举报 进行投诉反馈!